El Deep Learning y el SEO

Hace ya algunos meses que el máximo responsable del buscador de Google, Amit Singhal, anunció su salida de la empresa, hay que recordar que era el responsable de algoritmos que nos han traido de cabeza a los profesionales SEO durante años, pero la cosa no termina ahí, ya que Google anunció que su sustituto iba a ser John Giannandrea, quien hasta este momento era responsable del área de Inteligencia Artificial de Google.

Hace ya algunos meses que el máximo responsable del buscador de Google, Amit Singhal, anunció su salida de la empresa, hay que recordar que era el responsable de algoritmos que nos han traido de cabeza a los profesionales SEO durante años, pero la cosa no termina ahí, ya que Google anunció que su sustituto iba a ser John Giannandrea, quien hasta este momento era responsable del área de Inteligencia Artificial de Google.

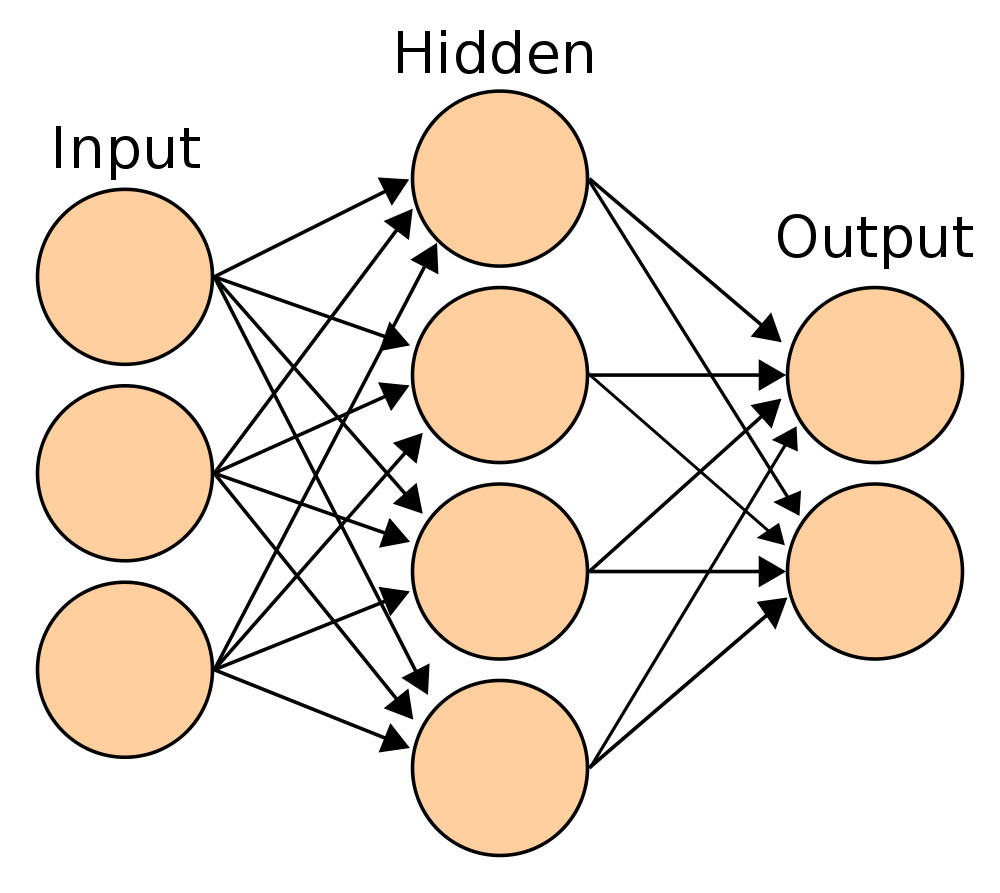

Dicho así puede parecer que este cambio no debería afectar a la forma en que hemos entendido los Consultores SEO el posicionamiento SEO, sin embargo nada más lejos de la realidad, ya que nos enfrentamos a un nuevo reto, pasar del SEO basado en algoritmos a un SEO basado en redes neuronales, el llamado Deep Learning (aprendizaje profundo), el Deep Learning utiliza un proceso matemático que imita el funcionamiento de la red neuronal del cerebro y centra su funcionamiento en dotar a los motores de búsqueda de un aprendizaje basado en Inteligencia Artificial. La red de neuronas digitales se estructura en distintas capas y cada una de estas capas reconoce y almacena aquellos datos que obtiene en el buscador, elige las entradas con mayor nivel de utilización y las filtra a la siguiente capa, así sucesivamente hasta que la capa superior de la red neuronal que se genera es capaz de comprender al combinar las distintas capas que contenido va a encontrar a continuación del texto contenido en la entrada de datos, dicho así puede parecer complicado pero realmente es mucho más sencillo de lo que pueda parecer entender el concepto de Deep Learning, es cómo un gran juego de Scrabble donde cada letra tiene un valor, y ese valor da un total sobre una palabra, si encadenamos un conjunto de valores, este nos devolverá una cadena de combinaciones de palabras prácticamente infinita, además de ese valor va a deducir los sinónimos y palabras relacionadas con el conjunto de palabras original. Este formato de Deep Learning es el utilizado en el reconocimiento facial en departamentos policiales de investigación, y en base al estudio de los pixel de las facciones es capaz de reconocer y mostrar los resultados que más se asemejan según el patrón de pixel introducido.

¿Qué es el Deep Learning?

Antes de profundizar en el Deep Learning, creo que es importante hacer una aproximación al significado del aprendizaje profundo y cómo se ha ido gestando, en realidad el Deep Learning no es ni mucho menos un concepto nuevo, tendriamos que remontarnos varias décadas atras para comprobar como determinados ordenadores eran programados para tomar decisiones según determinados procesos matemáticos, en la época, la capacidad y velocidad de trabajo de los ordenadores era mucho menor que ahora y por tanto con resultados bastante mediocres, pero es con la aparición del Big Data que el Deep Learning empieza a tomar forma. Alguien de repente se da cuenta que en el mundo que nos rodea hay millones de datos a los que no damos ninguna utilidad, conexiones de teléfonos móviles, conexiones telefónicas convencionales, uso de distintos servicios públicos y un sinfín de aplicaciones que estaban dejando millones de datos que no eran utilizados para nada y que podía ayudar a comprender el comportamiento de las personas ante determinadas situaciones y cómo las máquinas podian ayudar a optimizar esos comportamientos, en relidad se trataba de generar grandes bases de datos donde se analizasen todos esos datos «perdidos» y darles utilidad, las máquinas eran capaces de funcionar y reaccionar en función de esos conjuntos de datos que analizaba en cienmillonesimas de segundo. Con el mejor uso del Big Data las máquinas de aprendizaje profundo empezaban a tener un conjunto de señales que podian analizar y aprender de ellas, los datos se dividian  y distribuian en capas donde se creaba una determinada jerarquía de conceptos para poder utilizar con posterioridad, en realidad se trataba de una aprendizaje supervosado, lejos de la prestensión actual de dotar al Deep Learning de un aprendizaje profundo no supervisado, en realidad no son necesarias más de dos capas de información para que una máquina pueda jerarquizar conceptos y empezar a tomar decisiones en función de su capacidad de aprender, pero a mayor número de capas mayor exactitud en el resultado obtenido. Los Big Data «perdidos» empezaban a mostrar su utilidad en beneficio de las personas, y una de las aplicaciones que cabe destacar en el uso combinado de Big Data y Deep Learning tiene su máximo exponente en Smart Cities, ciudades «inteligentes» pensadas para hacer la vida más fácil a los ciudadanos, donde todos estos datos procesados pueden decidir desde los puntos de luz que deben permanecer activos en una determinada calle en función del uso, hasta variar la frecuencia de cambio de semáforos o la frecuencia de paso del transporte público en función de la utilización aportada por los distintos usuarios sobre el uso de esos equipamientos. Por tanto el Deep Learning, el aprendizaje profundo no supervisado, en su versión original está pensado para hacernos la vida un poco más sencilla, otra cosa es el provecho que se puede obtener de esos millones de datos con otras finalidades menos «sociales»

y distribuian en capas donde se creaba una determinada jerarquía de conceptos para poder utilizar con posterioridad, en realidad se trataba de una aprendizaje supervosado, lejos de la prestensión actual de dotar al Deep Learning de un aprendizaje profundo no supervisado, en realidad no son necesarias más de dos capas de información para que una máquina pueda jerarquizar conceptos y empezar a tomar decisiones en función de su capacidad de aprender, pero a mayor número de capas mayor exactitud en el resultado obtenido. Los Big Data «perdidos» empezaban a mostrar su utilidad en beneficio de las personas, y una de las aplicaciones que cabe destacar en el uso combinado de Big Data y Deep Learning tiene su máximo exponente en Smart Cities, ciudades «inteligentes» pensadas para hacer la vida más fácil a los ciudadanos, donde todos estos datos procesados pueden decidir desde los puntos de luz que deben permanecer activos en una determinada calle en función del uso, hasta variar la frecuencia de cambio de semáforos o la frecuencia de paso del transporte público en función de la utilización aportada por los distintos usuarios sobre el uso de esos equipamientos. Por tanto el Deep Learning, el aprendizaje profundo no supervisado, en su versión original está pensado para hacernos la vida un poco más sencilla, otra cosa es el provecho que se puede obtener de esos millones de datos con otras finalidades menos «sociales»

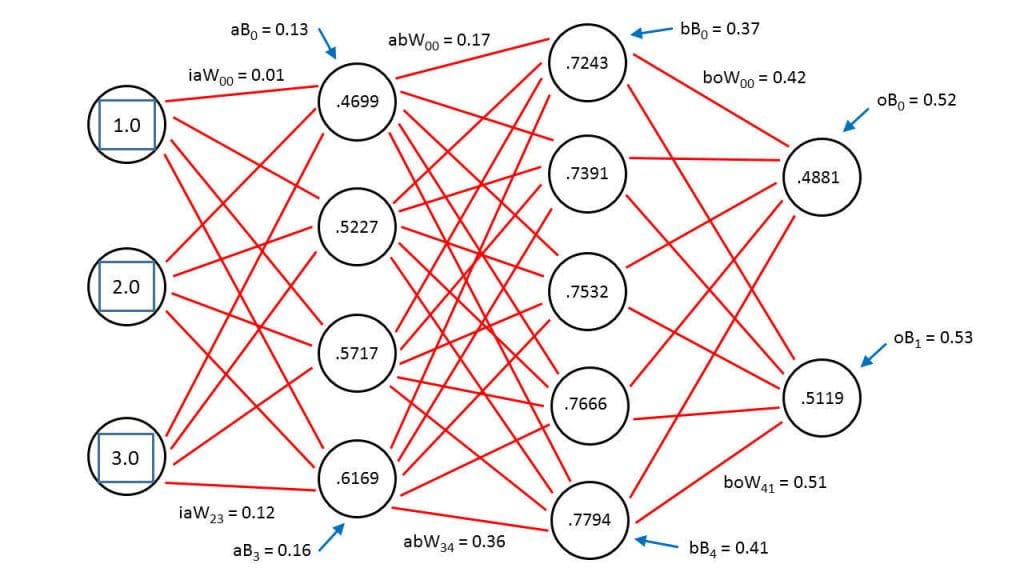

El enfoque general del Deep Learning consiste en dotar a la máquina de un conjunto de datos a la entrada, que una vez jerarquizados y parametrizados devuelvan una salida coherente sobre millones de combinaciones posibles, la máquina debe aprender de estos datos en función de la jerarquía que ocupan en cada una de las capas de aprendizaje profundo, en este punto el aprendizaje no se puede considerar aún Inteligencia Artificial ya que precisa de una gran intervención humana para determinar cómo se va a realizar la minería de datos para extraer los mejores resultados y entre ellos los más adecuados en función de la necesidad de cada usuario. El objetivo del Deep Learning es en realidad que la máquina sea capaz de comprender que reacción debe adoptar ante un conjunto de datos de entrada y en base a lo que tiene aprendido hasta ese momento, no obstante la virtud de este aprendizaje profundo es que la nueva entrada pasa a ocupar su lugar en la capa de entrada y genera un conjunto de variaciones de jerarquía que se utilizarán en la siguiente entrada relacionada, pero hecha esta breve introducción veamos como funciona el Deep Learning de Google y como afecta al SEO y como va a ser fundamental su conocimiento para aprovechar todo ese aprendizaje profundo en beneficio del posicionamiento web.

Deep Learning y Google

El Deep Learning de Google empezó a hacer sus pruebas hace ya unos años con un sistema de reconocimiento de datos que funciona como una red neuronal de 9 capas y estas 9 capas de la red de Deep Learning consta de un billón con B de conexiones, estas pruebas analizaron 10.000.000 de objetos y devolvió resultados sobre 22000 de ellos con un 16% de precisión, nadie habia progamado la red neuronal para aprender de forma directa como debía reconocer objetos ni lo que contenía ninguno de ellos, se trataba por primera vez del aprendizaje profundo no supervisado y que hablaba de la «Construcción de alto nivel utilizando el aprendizaje no supervisado a gran escala«.

En principio este aprendizaje profundo no supervisado estaba pensado para multitud de aplicaciones, reconocimiento facial, reconocimiento de voz, establecimiento de un aprendizaje del lenguaje, entre otras, vehiculos que no necesitan conductor, pero aquí es justo donde empieza la creación del Deep Learning como herramienta de búsqueda capaz de aprender en función de lo que el usuario introduce en el motor de búsqueda.

La construcción de un conjunto de redes neuronales capaz de comprender tantas variables resultaba un tanto compleja, y en realidad la solución estaba mucho más cerca de lo que pueda parecer, se trata de comprender como funciona la red neuronal del cerebro humano para determinar la acción que hay que realizar a continuación, por tanto la capacidad de crecimiento de la red neuronal en la que se fundamenta el Deep Learning es tan amplia como la capacidad de crecimiento de la red neuronal del cerebro humano, si tenemos en cuenta que nuestra consciencia controla aproximadamente el 2% del cerebro, el 98% restante es controlado por el subconsciente y es en el subconsciente donde se centra el Deep Learning, en almacenar un conjunto de datos aprendidos para generar una respuesta posterior, las redes neuronales del cerebro compiten entre si para desarrollar determinadas tareas, de tal forma que es la combinación de redes la que determina el resultado de la acción y de ahí nacen nuestro hábitos.

¿En qué afecta el Deep Learning al posicionamiento de una web?

En mi opinión la pregunta debería ser inversa, ¿en qué no afecta el Deep Learning al SEO?, después de leer un sinfín de artículos para documentar este post, la primera conclusión es que la forma de entender el SEO tiene que cambiar de forma abismal, casi va a ser un vuelco total, pero no todo son malas noticias. La implementación del Deep Learning va a ser progresiva, en tanto la red neuronal se nutre de aquellos datos necesarios para  perfeccionarse ya que aún presenta muchas incoherencias, un ejemplo reciente que puedo aportar para demostrar un error del Deep Learning de Google: al buscar «social media marketing» usando el modo incógnito en Google.es, te devuelve un gran número de resultados en inglés, incluso la Wikipedia hace una interpretación «natural» del término y te devuelve «Mercadotecnia en medios sociales», traducción literal del término de búsqueda. ¿Porqué ocurre esto? La respuesta es sencilla, la primera aplicación que se utilizó para dar forma al Deep Learning era el «famoso» traductor online de Google, todos sabemos lo patéticos que son los resultados en algunos idiomas, pues bien esas «capas de redes neuronales» siguen vigentes y forman parte del Deep Learning actual, si bien es cierto que están mejorando gracias a las propias aportaciones de traducciones por parte de los usuarios. Todos estos factores apuntan a que el tan conocido SEO semántico por fin se va a imponer por encima del resto de factores de indexación, cada vez va a ser mayor la capacidad de aprendizaje de los motores de busqueda y por tanto cada vez van a entender más y mejor el contenido publicado, no se trata de que lean el contenido, se trata de que lo van a leer y lo van a comprender.

perfeccionarse ya que aún presenta muchas incoherencias, un ejemplo reciente que puedo aportar para demostrar un error del Deep Learning de Google: al buscar «social media marketing» usando el modo incógnito en Google.es, te devuelve un gran número de resultados en inglés, incluso la Wikipedia hace una interpretación «natural» del término y te devuelve «Mercadotecnia en medios sociales», traducción literal del término de búsqueda. ¿Porqué ocurre esto? La respuesta es sencilla, la primera aplicación que se utilizó para dar forma al Deep Learning era el «famoso» traductor online de Google, todos sabemos lo patéticos que son los resultados en algunos idiomas, pues bien esas «capas de redes neuronales» siguen vigentes y forman parte del Deep Learning actual, si bien es cierto que están mejorando gracias a las propias aportaciones de traducciones por parte de los usuarios. Todos estos factores apuntan a que el tan conocido SEO semántico por fin se va a imponer por encima del resto de factores de indexación, cada vez va a ser mayor la capacidad de aprendizaje de los motores de busqueda y por tanto cada vez van a entender más y mejor el contenido publicado, no se trata de que lean el contenido, se trata de que lo van a leer y lo van a comprender.

Por otra parte, al tratarse de un aprendizaje profundo no supervisado es terriblemente complicado saber en base a un único algoritmo que factores va a utilizar el motor de búsqueda para devolver resultados y por tanto es muy difícil saber como los resultados están relacionados entre si en las distintas capas de las redes neuronales. Sin embargo hay una serie de factores que si van a empezar a tener una gran importancia y son factores que en SEO no tenían apenas importancia hasta hoy, el más claro y en el cual llevamos ya algun tiempo trabajando es el validador de W3C, el marcado de datos válido aporta una gran cantidad de información de utilidad al Deep Learning, este basa la validación en un algoritmo basado en Inteligencia Artificial que se supone ya es capaz de entender aquello que se muestra en el código fuente de la página. Por otra parte nadie nos garantiza que el motor de búsqueda, en su aprendizaje, utilice factores que escapen al control del mismo Google para clasificar los resultados de búsqueda.

Los propios ingenieros de Google reconocen no ser capaces de indicar con total seguridad bajo que conceptos se muestra un resultado por delante de otros, por tanto mucho menos capaces lo son los SEO, sin embargo el SEO cómo vehiculo para llevar un resultado más arriba que otros seguirá vigente, lo único que tendrá que variar obligatoriamente su técnica, el SEO «estandard» como tal tiene los días contados, será necesario evolucionar hacia nuevas técnicas de aprendizaje profundo de las máquinas para comprender como efectuar las labores de posicionamiento.

Posicionamiento SEO centrado en Deep Learning

El posicionamiento centrado en Deep Learning va a sufrir una mutación hacía un punto de vista más biológico de las búsquedas y mucho menos matemáticos, todo ello a pesar de que el centro neuralgico de la Inteligencia Artificial sigue siendo una máquina, una máquina que utiliza procesos matemáticos para tomar sus decisiones, la cuestión es cuanto es capaz de aprender la máquina y cuanto le pueden enseñar los SEO, efectivamente, este es el punto de inflexión. Bajo mi punto de vista el trabajo del SEO va a ser mucho más didáctico, va a centrar su estrategia en hacer que la máquina entienda que es lo que quiere explicar en un determinado contenido y por tanto seguirán teniendo importancia las densidades de palabras clave en un determinado contexto, obviamente el Deep Learning aprende de las búsquedas de usuarios, pero sería muy pobre si se basa sólo y exclusivamente en ello, también va a aprender del contenido de los textos quienes en base a la riqueza semántica van a aportar un mayor conocimiento al Deep Learning, aumentando su capacidad de comprensión al comparar con las construcciones de las palabras de búsqueda, puede parecer un juego de aprendizaje bilateral y creo que ahí es donde va a radicar el trabajo del SEO en las próximas decadas, no hace mucho tenía ante mi un artículo que trataba de argumentar la muerte del SEO a consecuencia del Deep Learning, y en mi opinión es justo lo contrario, el funcionamiento de las redes neuronales artificiales va a tener que aprender de las construcciones que los verdaderos especialistas en SEO propongan, y estos van a tener que aprender de los resultados que las redes neuronales les devuelvan, no va a ser ni más difícil ni más sencillo, simplemente las reglas del juego están cambiando y es el momento de adaptarse a una nueva fórmula de juego.

Tenemos que empezar a comprender un futuro en el cual los cambios de algoritmo no lo van a decidir los ingenieros, va a ser la Inteligencia Artificial quien determine las combinaciones necesarias para posicionar por encima o por debajo en los resultados, por tanto, lo más probable es que las técnicas a aplicar vayan cambiando en función de los hábitos de los usuarios y no en base a los distintos cambios de algoritmo matemático. Bajo mi punto de vista el algoritmo Penguin ya iba en este sentido y debo reconocer que me ha costado mucho entender el objetivo de ese cambio de algoritmo, en principio me pareció que estaba orientado a penalizar aquellas web que utilizaban técnicas similares al SPAM en su construcción, sin embargo despues de adentrarme un poco en profundidad en el Deep Learning, estoy cada vez más convencido de que era un primer test de como la Inteligencia Artificial era capaz de identificar determinadas prácticas sospechosas de SEO, por contra el algoritmo Penguin parecía comprender el contenido relacionado y publicado en redes sociales, sobre todo en aquellas que permiten el intercambio de imágenes como Pinterest o Instagram y los videos como YouTube y Vimeo, Penguin enviaba directamente a la profundidad del abismo aquellos sitios web que intercalaban contenidos y palabras clave no relacionadas directamente con lo que en el contenido se mostraba, estaba en definitiva aprendiendo del aumento de los recursos de imagen y video que tanto engagement dan a nuestras publicaciones para determinar que contenido no era compatible con aquello que se estaba mostrando.

El siguiente avance en Deep Learning es, bajo mi punto de vista el AMP (Accelerated Mobile Pages) donde se prima por delante de cualquier calidad estética al propio contenido, se muestra el contenido en su versión amp casi como si de un texto plano se tratase y las imágenes mal etiquetadas simplemente son ignoradas y no se muestran, se buscan dos cosas básicamente, la primera mejorar la carga y el visionado de las páginas AMP en los dispositivos móviles y en segundo la calidad del contenido, en función de si tienes un sitio web optimizado para AMP o no, tu página web va a adquirir mayor autoridad, el proyecto AMP cómo todos aquellos que son de código abierto basa su funcionalidad en las aportaciones de desarrolladores y estos desarrolladores son quienes deciden aquello qué es realmente importante y lo que es secundario, curiosamente ambos proyectos son puestos en marcha casi de forma simultanea, AMP en noviembre 2015 y Deep Learning en Enero 2016 tras la incorporación a la dirección del producto estrella de Google, el buscador, de John Giannandrea.

El usuario, el gran protagonista del Deep Learning

Si realmente hay un factor que me tiene enganchado al conocimiento en profundidad del Deep Learning, es precisamente cómo el buscador va a devolver los resultados basados en la experiencia de usuario. Google ya utiliza esta parte del Deep Learning en Google Adwords, ya que en base a las preferencias del usuario y a sus búsquedas recientes, le reconoce y muestra anuncios relacionados con sus últimas búsquedas, por tanto, y si el Deep Learning avanza en esta fórmula, los resultados se van a mostrar en base a la edad del usuario, su sexo, sus principales intereses, información de la cual Google ya dispone actualmente, en lugar de mostrar aquellos resultados más aproximados al término de búsqueda, por tanto será mucho más personalizado el motor de búsqueda y este es el principal punto donde deberemos trabajar el SEO basado en Deep Learning, en establecer perfiles de usuario para nuestros clientes y dejar de pensar en palabras clave, Google ya ha anunciado hace relativamente poco que, por ejemplo, la palabra clave en la url iba a perder peso en el posicionamiento con respecto a otros factores como puedan ser el contenido. Parece que estamos ante la desaparición paulatina de los algoritmos tal y como los conocemos hasta hoy, la construcción de enlaces, el SEO onpage, incluso las url amigables están en peligro de extinción a medio plazo, tenemos que centrar nuestros esfuerzos en la experiencia de usuario en nuestras páginas sea la mejor posible y por tanto la optimización SEO va a cambiar hacia este nuevo enfoque.

Si realmente hay un factor que me tiene enganchado al conocimiento en profundidad del Deep Learning, es precisamente cómo el buscador va a devolver los resultados basados en la experiencia de usuario. Google ya utiliza esta parte del Deep Learning en Google Adwords, ya que en base a las preferencias del usuario y a sus búsquedas recientes, le reconoce y muestra anuncios relacionados con sus últimas búsquedas, por tanto, y si el Deep Learning avanza en esta fórmula, los resultados se van a mostrar en base a la edad del usuario, su sexo, sus principales intereses, información de la cual Google ya dispone actualmente, en lugar de mostrar aquellos resultados más aproximados al término de búsqueda, por tanto será mucho más personalizado el motor de búsqueda y este es el principal punto donde deberemos trabajar el SEO basado en Deep Learning, en establecer perfiles de usuario para nuestros clientes y dejar de pensar en palabras clave, Google ya ha anunciado hace relativamente poco que, por ejemplo, la palabra clave en la url iba a perder peso en el posicionamiento con respecto a otros factores como puedan ser el contenido. Parece que estamos ante la desaparición paulatina de los algoritmos tal y como los conocemos hasta hoy, la construcción de enlaces, el SEO onpage, incluso las url amigables están en peligro de extinción a medio plazo, tenemos que centrar nuestros esfuerzos en la experiencia de usuario en nuestras páginas sea la mejor posible y por tanto la optimización SEO va a cambiar hacia este nuevo enfoque.

El Deep Learning y las redes sociales

Tras el anuncio a bombo y platillo de que Google iba a mostrar en sus resultados de búsqueda contenidos de Twitter, no había otra intención que conseguir que el Deep Learning mejorase sus procesos, que mejor forma de aprender que utilizar textos cortos en la tarea de aprendizaje, el proceso es simple y, a pesar de las disputas entre Twitter y Google, este aprendizaje profundo se está utilizando y con gran efectividad. El factor de éxito de Twitter es precisamente que los Tweets deben condensar en 140 caracteres una opinión, un mensaje, incluso la apertura de un debate con la utilización de los #hashtag relevantes en el contenido y este factor es utilizado por el Deep Learning para aprender las palabras más relevantes dentro de un contenido, a la Inteligencia Artificial lo que más le interesa es la utilización de las palabras importantes dentro del contexto pasando por alto algunas de las riquezas que tiene nuestro idioma cómo pueda ser el uso de pronombres personales, los cuales parece no ser capaz de identificar en función de si llevan tílde, algunas de las preposiciones más utilizadas para la construcción de locuciones prepositivas, esto hace que en nuestro idioma algunas construcciones queden algo huerfanas al haber sentado las bases de las redes neuronales del aprendizaje profundo partiendo del idioma inglés. En este punto cabe destacar que Google ya lleva tiempo educando nuestra forma de buscar para no utilizar este tipo de construcciones y por ejemplo una búsqueda que debería contener una construcción parecida a esta: «constructor de barcos en  Valencia» a pasado a realizarse de la siguiente forma por parte de la gran mayoría de usuarios: «constructor barcos Valencia», de aquí Deep Learning ha entendido que no es necesario tener en cuenta las preposiciones ya que los usuarios no las utilizamos en nuestras búsquedas, sin embargo en Redes Sociales cómo Facebook y Google + donde se realizan construcciones semánticas mucho más ricas, el Deep Learning ha encontrado una fuente de recursos sobre los cuales comparar con el resto de búsquedas y de esta forma ya empezamos a encontrar diferencias en el posicionamiento de distintas palabras en función de la construcción de palabras clave de long tail donde el uso de nuestros recursos gramaticales empiezan a posicionar, sin embargo al realizar este tipo de búsquedas nos damos cuenta como el volumen de búsquedas es muy inferior en este tipo de construcciones, factor el cual ha hecho que los profesionales SEO opten por trabajar sus long tail en base a palabras clave que no utilicen preposiciones o pronombres.

Valencia» a pasado a realizarse de la siguiente forma por parte de la gran mayoría de usuarios: «constructor barcos Valencia», de aquí Deep Learning ha entendido que no es necesario tener en cuenta las preposiciones ya que los usuarios no las utilizamos en nuestras búsquedas, sin embargo en Redes Sociales cómo Facebook y Google + donde se realizan construcciones semánticas mucho más ricas, el Deep Learning ha encontrado una fuente de recursos sobre los cuales comparar con el resto de búsquedas y de esta forma ya empezamos a encontrar diferencias en el posicionamiento de distintas palabras en función de la construcción de palabras clave de long tail donde el uso de nuestros recursos gramaticales empiezan a posicionar, sin embargo al realizar este tipo de búsquedas nos damos cuenta como el volumen de búsquedas es muy inferior en este tipo de construcciones, factor el cual ha hecho que los profesionales SEO opten por trabajar sus long tail en base a palabras clave que no utilicen preposiciones o pronombres.

Además de la construcción semántica de los textos, las redes sociales están haciendo otra aportación al Deep Learning, ya que los usuarios muestran en redes sociales sus preferencias, sus perfiles personales y sus afinidades con otros usuarios, esto permite a la Inteligencia Artificial el aprendizaje y segmentación de los usuarios en función de grupos de interés, lo cual le va a permitir al Deep Learning agrupar a estos usuarios según sus preferencias y mostrar resultados similares a todos ellos.

Facebook en concreto trabaja desde hace tiempo en su propio proyecto de Deep Learning, con una ventaja significativa con respecto a Google, y esta ventaja es precisamente el acceso a los datos personales de los usuarios, a sus preferencias y a sus estilos de vida, no tiene la necesidad de averiguar ya que es el propio usuario quien introduce estos datos en Facebook para mejorar su perfil, algo en lo que Google está en desventaja, la gran diferencia es que este aprendizaje es supervisado en cierto modo por Facebook, ya que son los mismos usuarios quienes deciden a quien mostrar sus contenidos y por tanto el aprendizaje profundo es «menos natural». Facebook utiliza el Deep Learning en sus resultados de búsqueda, pero también en el análisis de sus anuncios, ya que es precisamente en Facebook Ads donde mayor explotación está haciendo (por ahora) del aprendizaje profundo, el ejemplo más claro es la fórmula para aprobar o no una imagen para los anuncios en función del texto contenido en la imagen, el análisis pixel a pixel de la imagen devuelve que cantidad de texto puede aparecer en el interior de la imagen, nunca superior al 25% y este reconocimiento es lo que permite aprobar una imagen o no en función de como esta construida, a pesar del anuncio por parte de Facebook de la retirada de esta norma de forma inminente. En cuanto al motor de búsqueda de Facebook el Deep Learning también está evolucionando hacia un aprendizaje menos supervisado, es cieto que el uso de etiquetas tipo #hashtag en Facebook no está lo suficientemente extendido, sin embargo el motor de búsqueda de Facebook ha aprendido mucho de estas etiquetas desde que adquirió Instagram donde las etiquetas juegan un papel fundamental, el banco de objetos en la red neuronal de Facebook es inmenso gracias a sus propias imágenes y a las de Instagram, y el etiquetado le ha ayudado a comprender con qué se relaciona ese contenidom es por este aprendizaje que vemos cómo algunas imágenes, pocas por ahora, son censuradas en función de aquello que se muestra, recordemos el caso hace unos meses del «famoso pezón de Nuria Roca» el cual fue censurado en varias ocasiones tras efectuar varias revisiones de la imagen, sin embargo otras imágenes mucho más explicitas se siguen mostrando en Instagram y Facebook con total impunidad, de ello deduzco que a la Inteligencia Artificial le queda aún mucho por aprender.

El diseño web y el Deep Learning

En las tendencias de SEO actuales ya hemos visto en anteriores post la importancia que adquiere una buena arquitectura de diseño web, pero si el Deep Learning se impone y finalmente ofrece los resultados de búsqueda en función de las preferencias de los usuarios, las páginas web deberán adaptarse también en este sentido mostrando contenidos afínes al usuario y no a la construcción básica de la web, en este sentido el equipo de Jardín de Ideas llevamos bastante tiempo trabajando en la forma en que podemos mostrar distintos contenidos en función de la visita recurrente al sitio web de determinados grupos de clientes. El objetivo es aprovechar el Deep Learning para mostrar distintas landing page, incluso un menú inteligente que cambie en función de los clics que realiza el usuario para ir aprendiendo sobre los intereses de los visitantes al sitio web para acabar componiendo un contenido «perfecto» que busca una mejor experiencia de usuario, ¿porqué obligar al usuario a navegar por toda nuestra web en búsqueda del contenido apropiado? Lo más sencillo sería mostrarlo directamente y por supuesto tener distintos modelos de Home en función de las preferencias mayoritarias, nuestra apuesta consiste en adaptar las distintas landing para conseguir que se muestre aquella que el usuario espera encontrar, dejando en segundo término las páginas que para él son accesorias. No está resultando una proceso sencillo, ya que los parametros que inciden en este aprendizaje y en la creación del algoritmo que permite que se muestren unas páginas u otras depende de multitud de variables que seguramente no se podrá aplicar, al menos por ahora, al universo de páginas web dado su coste, no obstante seguimos trabajando en ello y los resultados que estamos consiguiendo son sencillamente asombrosos.

El marketing online y el Deep Learning

Evidentemente y visto lo anteriormente expuesto el marketing online va a ir evolucionando hacia la utilización de la Inteligencia Artificial para el desarrollo de campañas de marketing online de las cuales el SEO quizá sea una de las estrategias principales, en cualquier caso estas redes neuronales no van a quedarse sólo en los resultados de búsqueda, los departamentos de Google y Facebook reconocen abiertamente que ni es su prioridad ni están lo suficientemente preparados para ofrecer este servicio de forma inmediata, pero si hay que empezar a tener en cuenta este aprendizaje profundo para ir adaptando nuestras estrategias de marketing en ese sentido. El marketing online establece entre sus máximas prioridades las conversiones en ventas de sus acciones programadas y es aquí donde debemos aprender a utilizar los medios tradicionales combinados con Deep Learning y centrar nuestros objetivos en las preferencias de los usuarios pero de una forma más segmentada, ya no van a servir estrategias generalistas que se basen en el número de búsquedas o en las tendencias de búsqueda de determinadas palabras clave, nos vamos a ver obligados a utilizar el aprendizaje obtenido del Deep Learning para preparar campañas mucho más dirigidas a públicos específicos, se trata de una especie de «embudo de ventas» donde cada vez el usuario es más selectivo y por tanto su identificación del producto o servicio corresponde más a sus preferencias que a los atributos conocidos del producto o servicio.

La tecnología de Deep Learning viene a revolucionar varios aspectos en la forma en que debemos aprovecharla en nuestras estrategias:

-

Segmentación del público objetivo:

- El Deep Learning identifica segmentos de público mucho más definidos y que puede bajo esa identigicación neuronal no supervisada agruparles por intereses permitiendo concentrar los esfuerzos hacia el nicho de público objetivo más concreto posible.

-

Recomendación de contenido

- Una vez completado el aprendizaje anterior, el Deep Learning nos permite preparar contenidos para esos grupos específicos de público objetivo, con lo cual el profesional SEO elige que contenidos mostrar y a que grupo de público dirigir los esfuerzos en función de sus intereses identificados, de esta forma el profesional SEO pasará a trabajar con patrones variables en función de la segmentación del público objetivo utilizando para ello ya no sólo palabras clave, sino trabajando con contenidos más estructurados donde se combinen texto, imagen y vídeo y dentro del cual se añadirá las palabras clave de preferencia del grupo de público objetivo elegido, las palabras clave ya no podrán ser tan exactas, es decir, si lo serán, pero en el contexto de una frase o de un texto completo, ya que será el Deep Learning quien decida en última instancia como debe presentar ese resultado en función de la experiencia de usuario adquirida en su aprendizaje no supervisado.

-

Orientación de los anuncios publicitarios

- Ya tenemos los dos conceptos prinicpales, el público onjetivo y los contenidos a mostrar, ahora es cuando debemos trabajar el formato de los anuncios y el Deep Learning también será fundamental en este aspecto, recordar que este texto está centrado en SEO, para SEM habrá que aplicar una técnica similar pero con algunas variaciones, ya que como hemos visto antes se toman en cuenta determinados factores fijos de aprendizaje profundo no supervisado. Los Meta títulos y la Meta descripción van a ser fundamentales para resumir el contenido, pero justo así, cómo un resumen, ya que si la entrada de datos no corresponde con el contenido en su contexto con la suficiente autoridad nos perderemos más allá de la zona de luz de la primera página, incluso cayendo al fondo del abismo de los resultados de búsqueda.

El Deep Learning y la minería de datos aplicada al SEO

A mi entender este va a ser uno de los factores más apasionantes con los que vamos a tener que trabajar a nivel de SEO pensando en Deep Learning, el aprendizaje profundo nos va a aportar una gran cantidad de datos referentes a las búsquedas que realizan los usuarios y aprender a utilizar la minería de datos en nuestro favor va a resultar fundamental. Si echamos la vista atrás nos damos cuenta de que las grandes compañias utilizan el Big Data y las señales sociales como parte fundamental de la minería de datos de la cual extraen datos concluyentes sobre las tendencias de sus usuarios y clientes, el análisis de estos datos nos aportan distintas conclusiones, pero la correcta aplicación de la minería de datos que nos va a aportar el Deep Learning nos permitirá trabajar y distinguir dos cuestiones básicas y que resultarán fundamentales si realmente pensamos en trabajar con estos datos.

A mi entender este va a ser uno de los factores más apasionantes con los que vamos a tener que trabajar a nivel de SEO pensando en Deep Learning, el aprendizaje profundo nos va a aportar una gran cantidad de datos referentes a las búsquedas que realizan los usuarios y aprender a utilizar la minería de datos en nuestro favor va a resultar fundamental. Si echamos la vista atrás nos damos cuenta de que las grandes compañias utilizan el Big Data y las señales sociales como parte fundamental de la minería de datos de la cual extraen datos concluyentes sobre las tendencias de sus usuarios y clientes, el análisis de estos datos nos aportan distintas conclusiones, pero la correcta aplicación de la minería de datos que nos va a aportar el Deep Learning nos permitirá trabajar y distinguir dos cuestiones básicas y que resultarán fundamentales si realmente pensamos en trabajar con estos datos.

Cómo principal dato fundamental, el Deep Learning nos va a permitir identificar el alcance real de nuestros contenidos en relación con las preferencias de búsqueda de los usuarios, se recogen no sólo los datos obtenidos de los resultados de búsqueda, sino que se recogen también las señales sociales generadas por esas mismas palabras clave y el conjunto de patrones de los usuarios que hacen referencia a esas palabras, con ello se consigue que el sistema aprenda de las búsquedas y de todas aquellas palabras que se recogen a continuación, lo ilustraré con un ejemplo, imaginemos que vamos a querer posicionar a una empresa que fabrica calzado deportivo, las principales búsquedas relacionadas podrían ser, comprar calzado deportivo, fabricante de calzado deportivo, calzado deportivo en (aquí la geolocalización), marcas de calzado deportivo, calzado deportivo para niños, calzado deportivo para mujeres, calzado deportivo para mujeres, marcas de calzado deportivo, tengamos en cuenta que el ejemplo que voy a mostrar a continuación es una simulación de como se comporta el aprendizaje profundo, para entrar más a fondo en cómo funciona el algoritmo deberiamos ver cada una de las fórmulas matemáticas que lo componen, en cualquier caso el dato importante es que mediante el Deep Learning la máquina va a ser capaz de comprender textos más complejos y no sólo palabras sueltas, siendo capaz incluso de deducir en función del texto introducido, que es aquello que el usuario espera encontrar a continuación, veamos como analiza estas palabras clave Deep Learning, para ello vamos a utilizar long tail para ver como Deep Learning devolvería el resultado exacto:

CAPA 1: INTRODUCCIÓN DEL TÉRMINO DE BÚSQUEDA

empresa fabricante de calzado deportivo

CAPA 2: COMPARACIÓN DE PALABRAS RELACIONADAS

CAPA 3: DONDE SE COMPARAN LOS DISTINTOS PERFILES Y SE SEGMENTAN LOS PRIMEROS RESULTADOS

- Tiendas de calzado deportivo

- Tiendas de calzado deportivo de marca

- Tiendas de la marca X de calzado deportivo

- Marcas económicas de calzado deportivo

- Marcas de calzado deportivo

- Primeras marcas de calzado deportivo

- Nivel adquisitivo bajo

- Nivel adquisitivo medio

- Nivel adquisitivo alto

Este mismo ejemplo para cada uno de los perfiles en función de sexo, edad y resto de perfiles, a mayor complejidad más exactitud en el resultado final, ya que la segmentación es mucho mayor

CAPA 4: DONDE SE EXTRAE UN PRIMER GRUPO DE RESULTADOS A COMPARAR

- Fabricante de calzado deportivo para hombre en Barcelona

- Tiendas de calzado deportivo para hombres en Barcelona

- Tiendas de calzado deportivo para hombre en Barcelona

- Tiendas de la marca X de calzado deportivo para hombre en Barcelona

- Tiendas de marcas económicas de calzado deportivo para hombre en Barcelona

- Tiendas de marcas de calzado deportivo para hombre en Barcelona

- Tiendas directas del fabricante de calzado deportivo en Barcelona

- Mejores tiendas de calzado deportivo en Barcelona

- Tiendas de primeras marcas de fabricantes de calzado deportivo en Barcelona

Este ejemplo es ficticio y no se corresponde con ningún análisis sobre la palabra clave, sólo es con objetivo de ilustrar la muestra

CAPA 5: DONDE SE COMPARAN LOS DATOS CON LOS CONTENIDOS DE LAS DISTINTAS PÁGINAS WEB QUE INCLUYEN ESTAS PALABRAS

Aquí las variables se pueden contar ya por varios Billones con B de combinaciones posibles y es en esta capa intermedia donde se produce el aprendizaje profundo más concreto, veamos como seguiría según el patrón anterior

- Fabricante de calzado deportivo para hombre en Barcelona grupo 1 de segmentación Sexo que busca tiendas de calzado deportivo para hombre

- Fabricante de calzado deportivo para hombre en Barcelona grupo 2 de segmentación Edad el cual busca tiendas de calzado deportivo para hombre joven

- Fabricante de calzado deportivo para hombre en Barcelona grupo 3 de segmentación Nivel de estudios que busca tiendas de calzado deportivo para hombre joven directa del fabricante

- Fabricante de calzado deportivo para hombre en Barcelona grupo 4 de segmentación Perfil económico que busca tiendas de calzado deportivo para hombre joven de una marca concreta y preferentemente directamente del fabricante

Es este el punto donde los datos obtenidos y aprendidos se van a cruzar con el resto de datos para buscar el máximo de proximidad al mostrar los datos finales

CAPA 6: HASTA AQUÍ LOS DATOS ERÁN CONCRETOS A PARTIR DE ESTA CAPA DE APRENDIZAJE ES DONDE SE CONCENTRA LA MAYOR ACTIVIDAD YA QUE SON LAS QUE ESTÁN MENOS DESARROLLADAS

Hasta aquí Deep Learning ha estado aprendiendo y tomando sus primeras decisiones, pero es a partir de aquí donde empieza el aprendizaje profundo de verdad

CAPA 7 Y SIGUIENTES: MUESTRA DE RESULTADOS Y COMPARACIÓN CON LOS RESULTADOS OBTENIDOS DE LA BÚSQUEDA

- Porcentaje de rebote

- Tiempo de estancia en la página

- Número de páginas vistas

Y en base a estos datos y otros muchos todavía no revelados pero que podemos intuir establece la posición en que se muestra una determinada página en el motor de búsqueda y esta posición irá variando en función de los resultados que vaya almacenando y de la experiencia de usuario sobre esos resultados

La idea final del proceso es que, en base a datos aportados por el usuario, sumados a los datos que la base de datos de Deep Learning contiene y multiplicado por el número de perfiles similares en ese tipo de búsquedas se obtienen unos resultados determinados, estos resultados son puestos de nuevo a disposición del aprendizaje para seguir aumentando su base de conocimiento. Al tratarse de un aprendizaje no supervisado es muy complejo adivinar cual va a ser la fórmula definitiva, pero cuanto más aprenda la máquina más vamos a tener que depurar las técnicas SEO para aprovechar todo el potencial que Deep Learning nos aporta.

Todas las segmentaciones posibles ofrecen un gran número de variables que se corresponden con las preferencias de los distintos usuarios, sin embargo hay que destacar un factor que podriamos denominar de «ruido», y que se va a corresponder con todos los errores que el aprendizaje profundo devuelva en sus resultados, el Deep Learning empieza pero no termina jamás su proceso, está en constante aprendizaje y ello le irá ayudando a distinguir entre el contenido relevante y ese «ruido» de los resultados para ir eliminando y depurando su aprendizaje. Recordemos que a pesar de ser un proceso matemático que se supone va a ser capaz de entender a las personas, las personas no respondemos a algoritmos matemáticos a pesar de que el Deep Learning se fundamente en el funcionamiento de las redes neuronales del cerebro humano, por tanto va a tener la necesidad de aprender de nuestros cambios de hábitos, de nuestro humor ante situaciones determinadas, incluso de nuestros cambios de preferencias, los análisis se han efectuado sobre un panorama «idílico», pero las personas cambiamos y esos cambios los tendra que asumir Deep Learning para perfeccionarse.

¿Y ahora qué?

Pues bajo mi punto de vista ahora toca aprender, evidentemente si dos grandes gigantes cómo son Google y Facebook están utilizando Deep Learning y sustituyendo los antiguos algoritmos, realmente algo se está moviendo, los ingenieros de ambas compañías son incapaces de adivinar el alcance final de la estructura de redes neuronales de Inteligencia Artificial y por tanto no seré yo quien les diga lo que va a suceder, pero si que entiendo que los usuarios tenemos la capacidad y una magnífica oportunidad de aportar a ese aprendizaje profundo las variaciones que nos eviten ver resultados que no nos inetresan lo más mínimo pero que contienen las palabras clave por las que hemos realizado la búsqueda. Es el momento de los usuarios y parece que el Deep Learning se centra de forma directa en satisfacer las necesidades de cada usuario y ofrecer los mejores resultados posible en función de sus intereses, pero mucho más allá de los intereses de búsqueda, por sus intereses sociales, por su condición económica, en función de sus aficiones deportivas, de su sexo y de su edad, afortunadamente nos quedan las búsquedas de incógnito para tratar de engañar a la máquina, aunque ya estamos viendo que incluso en modo incógnito los resultados mostrados son los más cercadnos a tu situación geográfica, con lo cual no estoy muy seguro de si Deep Learning también va a aprender de las búsquedas de incógnito para mostrar sus resultados.

Se aproxima una temporada apasionante para los profesionales en SEO y creo que va a ser determinante contar con un conjunto de características comunes, un buen dominio del lenguaje, una capacidad de interpretación de datos excelente y una optimización de todos los procesos de la construcción de la información depurado. Los desarrolladores de páginas web también tendremos que pensar cada vez más en la experiencia de usuario y dejar de utilizar algunos recursos que «adornan» pero son totalmente inútiles, centrar nuestro trabajo en mostrar aquello que el usuario espera encontrar y que sin una correcta determinación de los factores clave en la arquitectura de la página va a ser imposible elaborar, se acabó la epoca de la web bonita y empieza la época de la web útil, manejable y eficaz para efectuar conversiones, ya que el aprendizaje profundo analizará el código y determinará si tu página va a ser del agrado del usuario que aterrice en ella.